Nova studija Europske radiodifuzijske unije otkriva alarmantni broj grešaka među popularnim chatbotovima s umjetnom inteligencijom. Sustavi redovito izmišljaju informacije, pa čak i navode lažne izvore.

Pitaju ChatGPT o rezultatima izbora, traže od Claudea da sažme vijesti ili od Perplexityja da im da osnovne informacije o sukobu na Bliskom istoku: stotine milijuna ljudi svakodnevno se oslanjaju na chatbotove s umjetnom inteligencijom kao izvore informacija.

Samo ChatGPT svaki tjedan koristi 800 milijuna ljudi diljem svijeta

Za mnoge su ti digitalni asistenti već zamjena za tradicionalno pretraživanje na Googleu, piše Deutsche Welle (DW).

Ali to povjerenje je rizično, kao što pokazuje nova studija Europske radiodifuzijske unije (EBU). Udruga 68 javnih emitera iz 56 zemalja testirala je pouzdanost najpopularnijih sustava s umjetnom inteligencijom.

Rezultat je zastrašujući: ChatGPT, Claude, Gemini i drugi chatbotovi izmišljaju i do 40 posto svojih odgovora i predstavljaju ih kao činjenice.

Popularni chatbot ChatGPT čvrsto tvrdi da je papa Franjo još uvijek živ. Microsoftov Copilot, koji je integriran u uredske programe Word i Excel, ne zna da je Švedska u NATO-u. A Googleov Gemini smatra da je ponovni izbor Donalda Trumpa “moguć“, iako se to odavno dogodilo.

“Sustavi zvuče uvjerljivo, iako više puta tvrde potpuno lažne stvari“, upozorava ekonomist Peter Posch s Tehničkog sveučilišta u Dortmundu. “To ih čini posebno opasnima za neiskusne korisnike, jer pogreške često nisu odmah očite”.

Postoji fenomen koji stručnjaci nazivaju “halucinacija“: umjetna inteligencija izmišlja informacije koje djeluju koherentno, ali nemaju činjeničnu osnovu

To se osobito često događa kod regionalnih događaja, aktualnih zbivanja ili kada je potrebno povezati više informacija.

Ali što to znači za društvo u kojem sve više ljudi dobiva informacije od chatbota? Posljedice su već vidljive: lažne informacije brzo se šire društvenim mrežama jer korisnici dijele “činjenice“ koje generira umjetna inteligencija bez provjere. Učenici i studenti uključuju izmišljene informacije u svoje radove. Građani mogu donositi odluke o tome za koga će glasati na temelju lažnih tvrdnji.

Posebno je problematično to što mnogi korisnici nisu ni svjesni da chatbotovi mogu halucinirati. Oni pretpostavljaju da tehnologija funkcionira objektivno i činjenično, što je opasna zabluda. Sustavi umjetne inteligencije upozoravaju na moguće pogreške u svojim uvjetima korištenja ali – tko to uopće čita?

Šteta za ugled medija

Još jedan problem tiče se vjerodostojnosti etabliranih medija. Chatbotovi redovito tvrde da njihove izmišljene informacije dolaze iz takvih izvora kao što su, na primjer, njemački javni servisi ARD ili ZDF, iako oni o tome nikada nisu izvještavali – ili su izvještavali sasvim drukčije. Korisnici gube povjerenje u renomirane izvore kada umjetna inteligencija zloupotrebljava njihova imena za širenje lažnih informacija.

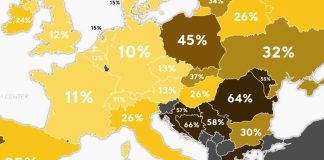

Studija EBU testirala je chatbotove sa stotinama činjeničnih pitanja: o povijesnim događajima, znanstvenim spoznajama i aktualnim vijestima. Ovisno o temi, stopa pogrešaka kretala se od 15 do čak 40 posto. Nijedna od testiranih umjetnih inteligencija nije radila besprijekorno.

Zašto umjetna inteligencija griješi?

Problem je u samom sustavu: chatbotovi zapravo ne razumiju što govore. Oni izračunavaju koje će riječi vjerojatno odgovarati na temelju golemih količina teksta i ne mogu provjeriti je li izjava koja je rezultat takvih izračuna točna. Oni nemaju znanje o činjenicama, imaju samo statističke obrasce.

Tehnološke kompanije svjesne su tih nedostataka i rade na rješenjima. Integriraju baze podataka, poboljšavaju navođenje izvora i dodatno obučavaju sustave. U razvoj se ulažu milijarde. Ipak, halucinacije ostaju temeljni, neriješeni problem te tehnologije.

EBU preporučuje jasna pravila za postupanje s chatbotovima: nikada im ne vjerovati slijepo, uvijek provjeravati važne informacije, za vijesti i činjenice oslanjati se na etablirane medije, a ne na umjetnu inteligenciju. Oprez se posebno savjetuje kada je riječ o političkim temama, zdravstvenim pitanjima ili financijskim odlukama.

Škole i sveučilišta moraju podučavati medijsku pismenost: kako prepoznati dezinformacije koje generira umjetna inteligencija, koji su izvori pouzdani …

Baš zanimljivo! Toliko prašine se podiglo kako ćemo eto konačno doći do pameti, a ta pamet je obična skalamerija. Kao i sve drugo što je čovjek napravio.